信息时代,“数据就是财富”。由于数万亿个数据集囊括了整个世界,因此数据是脆弱的。 保护数据势在必行,数据治理确保数据得到管理、安全且合规。

数据治理

数据治理忽视了数据。它列出了设置策略、确保可用性、安全性、完整性和安排性能指标的流程。数据治理至关重要,因为它奠定了监督和管理数据的基础。数据治理的核心是“数据政策和合规性”。

数据政策驱动组织中的数据,它是为数据设定标准的文档。数据政策和合规性文件讨论以下内容:

- 政策范围

- 负责团队

- 数据质量和完整性检查

- 数据安全到位

- 数据使用和访问

数据政策文档为组织奠定了数据基础。它描述了:

- 政策的范围有多大以及涵盖的内容。

- 参与管理、处理和监控数据的团队。它缩小了处理数据的人员范围,为数据创建了一个封闭的环境。

- 数据最重要的两个方面是正确性和完整性。数据正确性确保数据不存在差异,数据完整性确保使用的数据不包含任何个人或敏感信息。这两个方面都很脆弱,任何一个方面的偏差都可能产生重大影响。

- 保护数据同样重要。数据政策文件包括实施安全措施、缓解计划以及静态和传输数据加密的必要指南。它还制定数据泄露指南和时间表以及数据备份和恢复计划。

- 数据使用和访问可以被视为数据完整性和安全性的扩展部分。但它们是数据的一个重要方面。数据的用途和使用方式非常重要。设置访问策略可以加强数据的安全性。

DevOps 和数据治理

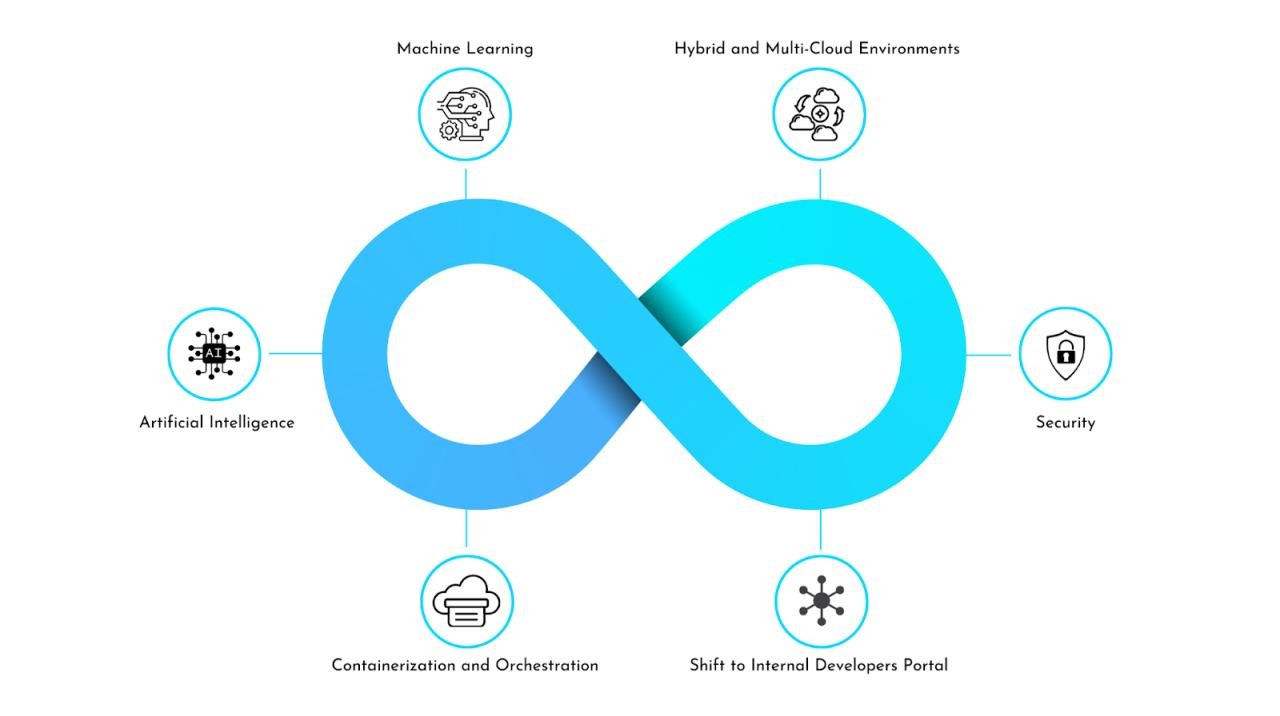

由于数据治理对数据项目具有重要价值,DevOps 思维方式可以提高数据治理流程的效率。 DevOps 非常重视简化和自动化,它将流程整合在一起并减少手动干预的需要。

数据治理有两个技术流程,其自动化可以带来显着的效益:

- 数据正确性和完整性涉及检查数据的准确性并确保不存在敏感信息。它可以是 ETL 管道的一部分。

- ETL 代表提取、转换和加载,是一种处理数据预处理步骤的自动化方法。提取数据后,可以进行数据清洗,修复不准确的数据和空列。 Pandas 库可用于清理数据。

- Faker 等 Python 库可用于用隐藏个人信息的随机数据替换敏感信息。

- 使用 Jenkins 等 CI/CD 工具 的 ETL 管道可以减少手动干预并按计划无缝运行以获取数据、检查正确性、维护完整性,并以自动化方式将转换后的数据加载到数据存储解决方案中。

- 数据安全可以分为两个子流程:

- 数据存储平台上的访问管理:访问管理自动化取决于数据存储所在的平台。例如,Amazon Redshift 等数据仓库解决方案或 Azure Data Lake Storage 等数据湖,因为在云平台上可以通过基础设施即代码 (IaC) 实现自动化诸如 Terraform 之类的解决方案。

对于独立的 SaaS 应用程序,可以使用 Python 等编程语言来使用 API。 - 数据可扩展性:通过使用 Terraform、Azure Bicep 或 AWS CloudFormation 等 IaC 实施 CI/CD 管道,可以轻松扩展数据。该管道可以分为两个方面:第一部分用于监视何时达到某个阈值,第二部分用于扩展存储。该管道还可以配置为根据需要缩小规模。

- 数据存储平台上的访问管理:访问管理自动化取决于数据存储所在的平台。例如,Amazon Redshift 等数据仓库解决方案或 Azure Data Lake Storage 等数据湖,因为在云平台上可以通过基础设施即代码 (IaC) 实现自动化诸如 Terraform 之类的解决方案。

结论

在一个以数据为基础的世界中,数据治理至关重要,因为它包含一个监督和管理数据的系统。因此,建立 DevOps 思维方式自然势在必行,这种思维方式可以整合治理流程并通过自动化简化它们。