实现将 Apache Kafka 与 AWS RDS 并使用 AWS Lambda 和 API 网关,将数据馈送到 Web 应用程序中。以下是如何构建此解决方案的高级概述:

1。设置 Apache Kafka

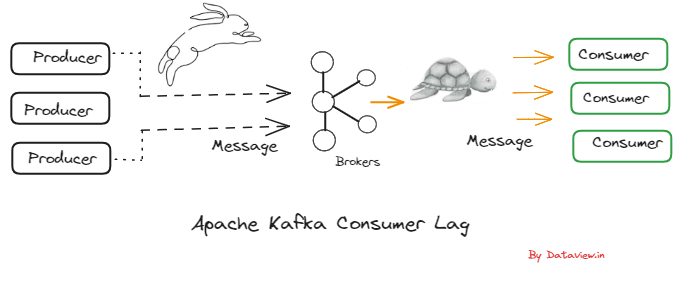

Apache Kafka 是一个分布式流媒体平台,每天能够处理数万亿个事件。要设置 Kafka,您可以将其安装在 EC2 实例上,也可以使用 Amazon Managed Streaming for Kafka (Amazon MSK),这是一项完全托管的服务,可以轻松构建和运行使用 Apache Kafka 处理流数据的应用程序。

选项 1:在 EC2 实例上设置 Kafka

启动 EC2 实例:选择适合您的工作负载的实例类型并在您的 AWS 账户中启动它。

安装 Kafka:通过 SSH 连接到您的实例并安装 Kafka。您可以按照 Kafka 快速入门指南进行操作。

启动Kafka服务:启动Kafka代理服务和Zookeeper服务。

创建 Kafka 主题:创建一个主题,您的生产者将写入该主题,您的消费者将从中读取内容

选项 2:设置 Amazon MSK

创建 Amazon MSK 集群:转到 Amazon MSK 控制台并创建新集群。选择您要使用的 Kafka 版本,并指定您需要的代理数量。

设置网络:确保您的 MSK 集群在 VPC 内设置,并具有正确的子网和安全组配置,以允许来自 EC2 实例或 Lambda 函数的流量。

创建 Kafka 主题:使用 AWS CLI 或 MSK 控制台创建您需要的 Kafka 主题:

aws kafka create-topic --cluster-arn "ClusterArn" --topic-name "flight-data" --partitions 1 --replication-factor 3

安全和监控

无论您选择哪种设置方法,请确保:

- 配置安全性:设置安全措施,例如传输中加密、静态加密和 IAM 策略来控制访问。

- 启用监控:为 Kafka 代理设置 CloudWatch 监控,以监控“UnderReplicatedPartitions”、“BytesInPerSec”和“BytesOutPerSec”等日志和指标。

Kafka 设置完成后,您可以生成和使用与航班数据相关的消息,从而实现实时分析和决策流程。 Kafka 将充当数据摄取的中央枢纽,处理高吞吐量并确保数据在架构的不同组件之间可靠地传输。

2.将数据写入AWS RDS实例

设置 Kafka 集群后,下一步是将数据写入 AWS RDS 实例。为此,您可以将 Kafka Connect 与 JDBC 接收器连接器结合使用,这将允许您将数据直接从 Kafka 主题流式传输到 RDS 表中。

设置您的 AWS RDS 实例

启动 RDS 实例:从 AWS 管理控制台启动新的 RDS 实例。选择您喜欢的 SQL 数据库引擎,例如 MySQL、PostgreSQL 或 SQL Server。

配置数据库:设置实例类、存储、VPC、安全组、数据库名称等参数。确保在数据库端口(例如 MySQL 的 3306)上允许来自 Kafka Connect 节点的入站流量。

创建数据库表:使用数据库客户端连接到您的 RDS 实例并创建将存储 Kafka 数据的表。例如,您可以为航班数据创建一个表:

配置 Kafka Connect

安装 Kafka Connect:如果尚未包含在 Kafka 安装中,请安装 Kafka Connect。在安装了 Kafka 的 EC2 实例上,您可以使用 Confluence Hub 客户端安装 Kafka Connect JDBC 连接器:

配置 JDBC 接收器连接器:为 JDBC 接收器连接器创建 Kafka Connect 配置文件。您需要指定详细信息,例如 RDS 端点、数据库凭据、要写入的表以及自动创建表等任何其他行为。

启动 Kafka Connect:使用您的 JDBC 接收器配置运行 Kafka Connect 工作线程。

此过程将开始将数据从 Kafka 中的“flight-data”主题流式传输到 RDS 实例中的“flight_data”表。 `auto.create=true` 配置允许 Kafka Connect 根据主题架构自动在 RDS 中创建表。

监控和优化数据流

监控 Kafka Connect:密切关注 Kafka Connect 日志,确保数据正确高效地流动。请注意可能表明数据类型、网络连接或权限问题的错误或警告。

优化性能:根据数据量和速度,您可能需要调整 Kafka Connect 和 RDS 实例的性能。这可能涉及调整 Kafka Connect 中的任务数量、为 RDS 表建立索引或扩展 RDS 实例。

确保数据一致性:实施检查以确保写入 RDS 的数据与 Kafka 中的数据一致。这可能涉及比较计数、校验和或使用 Debezium 等工具进行变更数据捕获 (CDC)。

通过执行以下步骤,您可以有效地将来自 Apache Kafka 的实时数据写入 AWS RDS 实例,使下游应用程序能够根据最新的航班数据执行分析、生成报告或触发事件。

3。使用 AWS Lambda 从 RDS 读取数据

AWS Lambda 可用于从 AWS RDS 实例读取数据并将其提供给各种应用程序或终端节点。 Lambda 函数是无服务器的,这意味着它们可以根据需求自动扩展

配置 AWS Lambda 执行角色

创建 IAM 角色:转到 IAM 控制台并使用“AWSLambdaVPCAccessExecutionRole”策略创建一个新角色。此角色允许 Lambda 在 Amazon CloudWatch Logs 中执行和创建日志流。

附加 RDS 访问策略:创建策略并将其附加到 IAM 角色,以授予 Lambda 函数访问 RDS 数据库的权限。

{

"版本": "2012-10-17",

“陈述”: [

{

"效果": "允许",

“行动”: [

“rds-db:连接”

],

“资源”:[

“arn:aws:rds:区域:帐户 ID:数据库:数据库实例名称”

]

}

]

}

创建 Lambda 函数

定义函数:在 AWS Lambda 控制台中,从头开始创建一个新函数。选择与您的首选编程语言相匹配的运行时,例如 Node.js 或 Python。

设置 VPC:配置连接到您的 VPC 的功能,指定有权访问您的 RDS 实例的子网和安全组。

实现查询逻辑:编写函数代码连接到RDS实例并执行SQL查询以获取所需的数据。

这是一个在 Python 中使用 `pymysql` 的示例:

部署函数:配置函数并编写代码后,通过单击 AWS Lambda 控制台中的“部署”按钮来部署函数。

安排定期调用或按需触发

计划轮询:如果您需要定期轮询 RDS 以获取新数据,您可以使用 Amazon EventBridge(以前称为 CloudWatch Events)按计划触发 Lambda 函数。

按需调用:对于按需访问,您可以将 API 网关设置为触发器,以便在出现 HTTP 请求时调用 Lambda 函数。

错误处理和重试

实施错误处理:确保您的 Lambda 函数具有 try-catch 块来处理任何数据库连接问题或查询错误。

配置死信队列 (DLQ):设置 DLQ 来捕获和分析调用失败。

优化性能

连接池:使用 RDS Proxy 或在 Lambda 函数中实现连接池来重用数据库连接,从而减少为每个函数调用建立新连接的开销。

内存和超时:根据查询的复杂性和预期执行时间调整 Lambda 函数的内存和超时设置,以优化性能和成本。

监控和调试

监控日志:使用 Amazon CloudWatch 监控日志并针对 Lambda 函数执行期间可能发生的任何错误或性能问题设置警报。

跟踪和调试:利用 AWS X-Ray 跟踪和调试 Lambda 函数调用 RDS 查询时发生的情况。

通过执行这些步骤,您的 AWS Lambda 函数将能够高效地从 AWS RDS 实例读取数据。此设置支持无服务器处理数据请求,提供可扩展且经济高效的解决方案,用于将数据从 RDS 实例提供到应用程序架构的其他部分。

4。使用 API 网关向 Web 应用程序提供数据

AWS API Gateway 充当应用程序从后端服务访问数据、业务逻辑或功能的前门。通过将 API Gateway 与 AWS Lambda 集成(进而从 AWS RDS 实例读取数据),您可以高效地将实时数据提供给您的 Web 应用程序。以下是逐步设置的方法:

在 API Gateway 中创建新 API

导航到 API Gateway:转到 AWS 管理控制台,选择 API Gateway,然后选择创建新 API。

选择 REST API:选择“REST”,适用于无服务器架构和 Web 应用程序。单击“构建”。

配置 API:为您的 API 提供名称并设置任何其他配置,例如端点类型。对于大多数 Web 应用程序,区域端点是合适的。

定义新资源和方法

创建资源:在 API Gateway 控制台中,在您的 API 下创建新资源。该资源代表一个实体(例如“flightData”),并将成为 API URL(“/flightData”)的一部分。

创建 GET 方法:将 GET 方法附加到您的资源。 Web 应用程序将使用此方法来检索数据。

将 GET 方法与 AWS Lambda 集成

与 Lambda 集成:对于 GET 方法集成类型,选择 Lambda 函数。指定您之前创建的 Lambda 函数的区域和名称,该函数从 RDS 实例读取数据。

部署 API:将您的 API 部署到新的或现有的阶段。该部署使您可以通过互联网访问您的 API。请注意部署时提供的调用 URL。

启用 CORS(跨域资源共享)

如果您的 Web 应用程序托管在与 API 不同的域中,您需要在 API 网关上启用 CORS:

- 选择资源:在 API Gateway 控制台中选择您的资源(例如“flightData”)。

- 启用 CORS:选择“操作”下拉菜单,然后点击“启用 CORS”。根据应用程序的要求输入允许的方法、标头和来源并部署更改。

在您的 Web 应用程序中使用 API

使用调用 URL:在您的 Web 应用程序中,使用 API Gateway 部署中的调用 URL 向“/flightData”资源发出 GET 请求。您可以使用 JavaScript 的“fetch” API、Axios 或任何 HTTP 客户端库。

显示数据:收到数据后,根据需要对其进行处理并在 Web 应用程序的 UI 中显示。

6。监控和保护您的 API

保护和监控由 Apache Kafka、AWS RDS、AWS Lambda 和 API Gateway 组成的数据管道对于确保数据完整性、机密性和系统可靠性至关重要。以下是如何保护和监控管道的每个组件:

保护管道安全

-

Kafka 安全性:

- 加密:使用 TLS 加密 Kafka 代理和客户端之间传输的数据。

- 身份验证:实施 SASL/SCRAM 或双向 TLS (mTLS) 以进行客户端代理身份验证。

- 授权:使用 Kafka 的 ACL 控制对主题的访问,确保只有授权的服务才能生成或使用消息。

-

AWS RDS 安全性:

- 加密:使用 AWS Key Management Service (KMS) 启用静态加密,并通过与 RDS 实例的 SSL 连接强制执行传输加密。

- 网络安全:将您的 RDS 实例放置在 VPC 内的私有子网中,并使用安全组来限制对已知 IP 或服务的访问。

- 访问管理:使用 IAM 角色和数据库凭据授予数据库访问权限时遵循最小权限原则。

-

AWS Lambda 安全性:

- IAM 角色:将 IAM 角色分配给 Lambda 函数,并赋予其执行任务所需的最少权限。

- 环境变量:使用 AWS KMS 将数据库凭证等敏感信息存储在加密的环境变量中。

- VPC 配置:如果您的 Lambda 函数访问 VPC 中的资源,请使用 VPC 配置它以将其与公共互联网访问隔离。

-

API 网关安全:

- API 密钥:使用 API 密钥作为控制 API 访问的简单方法。

- IAM 权限:利用 AWS IAM 角色和策略进行更精细的访问控制。

- Lambda 授权方:实施 Lambda 授权方以进行 JWT 或 OAuth 令牌验证,以保护您的 API 端点。

- 限制:设置限制规则以保护您的后端服务免受流量峰值和拒绝服务 (DoS) 攻击。

监控管道

-

Kafka 监控:

- 使用 LinkedIn Cruise Control、Confluence Control Center 等工具或 Kafka Manager 等开源替代方案进行集群管理和监控。

- 监控消息吞吐量、代理延迟和消费者延迟等关键指标。

-

AWS RDS 监控:

- 利用 Amazon CloudWatch 监控 RDS 实例。关键指标包括 CPU 利用率、连接、读/写 IOPS 和存储使用情况。

- 启用增强监控以更详细地了解数据库引擎的性能和活动。

-

AWS Lambda 监控:

- 使用 Amazon CloudWatch 监控函数调用、错误和执行持续时间。

- 使用 AWS X-Ray 进行跟踪并深入了解函数执行流程和性能。

-

API网关监控:

- 利用 CloudWatch 监控 API 网关指标,例如 API 调用次数、延迟和 4XX/5XX 错误。

- 启用 CloudWatch Logs 来记录 API 的所有请求和响应,以用于调试和合规性目的。

安全和监控最佳实践

- 定期审核:定期审核安全组、IAM 角色和策略,以确保它们处于最新状态并遵循最小权限原则。

- 自动化安全性:使用 AWS Lambda 自动响应安全事件,例如撤销访问权限或隔离受影响的资源。

- 警报:在 CloudWatch 中针对异常活动或性能问题设置警报,以确保及时响应潜在问题。

- 数据隐私合规性:通过实施适当的数据处理和保护机制,确保您的管道符合 GDPR 或 CCPA 等相关数据隐私法规。

保护和监控数据管道是一个持续的过程,需要随时了解最佳实践和不断变化的威胁。通过实施强大的安全措施和监控系统,您可以保护您的数据并确保数据管道的可靠性和性能。