作为 iOS 用户,您一天与 Siri 交谈多少次?好很多次了,不是吗?如果你是一个敏锐的观察者,那么你知道Siri的声音听起来更像iOS 11中的人类比以前。这是因为 Apple 正在深入挖掘人工智能、机器学习和深度学习技术,为用户提供最佳的个人助理体验。

从引入 Siri 与 iPhone 4S 到iOS 11的延续,这个私人助理已经发展到更接近人类并与他们建立良好的关系。要回复用户的语音命令,Siri 使用语音合成与深度学习相结合。

语音合成:Siri 功能的组成部分

言语合成基本上是人工产生人类言语。该技术在虚拟个人助理、游戏和娱乐等多个领域是典型的。在单元选择和参数合成的基本模型取得一些进展的同时,深度学习已经深入到其中。

该技术在语音合成中的集成,催生了一种称为直接波形建模的新模型。有了这个模型,现在可以处理高质量的单元选择合成,并且利用参数合成的灵活性优势。

Apple 利用混合单元选择系统中深度学习的强大功能,为 Siri 获得最高质量的语音输出。

文本到语音转换系统 (TTS) 的工作原理

TTS 系统的工作原理是记录人类的声音,以用于可能的情况,将语音单元分叉,并使用机器学习。

记录人类的声音,以寻找可能的实例

为虚拟个人助理制作文本到语音转换系统的第一个主要任务是记录人类的声音。这个声音不仅应该令人愉快地听到,而且应该非常清楚地理解给每个人。

为了涵盖各种人类演讲,需要在专业工作室录制大约 20 小时的演讲。这包括几乎所有类型的响应,包括叙述说明、口述天气预报、讲笑话等。不能使用这些音频剪辑,因为它是,因为它没有限制的问题类型,任何用户可以问个人助理。然后处理这些记录的响应,以使虚拟助理了解它们。

机器学习的使用

虽然这听起来只是另一个过程,但对于开发人员来说,要完美地获得压力和语调模式(音高)是相当困难和具有挑战性的。此外,它太重,手机去与这种字符串的方法。

通过引入机器学习,这些挑战在一定程度上得到解决。通过收集训练数据,可以使文本到语音转换系统了解模式以及如何划分不同的音频元素,以提供自然的人样输出。

苹果努力改善 Siri 的声音

一旦他们决定严格努力提高 Siri 的语音,Apple 的工程师与一位女配音演员合作,用美国口音英语录制了 20 小时的演讲。这1-200万段音频片段随后用于训练深度学习系统。

接下来,他们测试输出,使主题从 Siri 以前的和新声音中进行选择。他们中的大多数人更喜欢新的自然和类似人类的 Siri 语音。当 Siri 回答琐事、确认”请求已完成”通知并提供其他导航说明时,他们注意到从机器人到自然声音的明显区别。

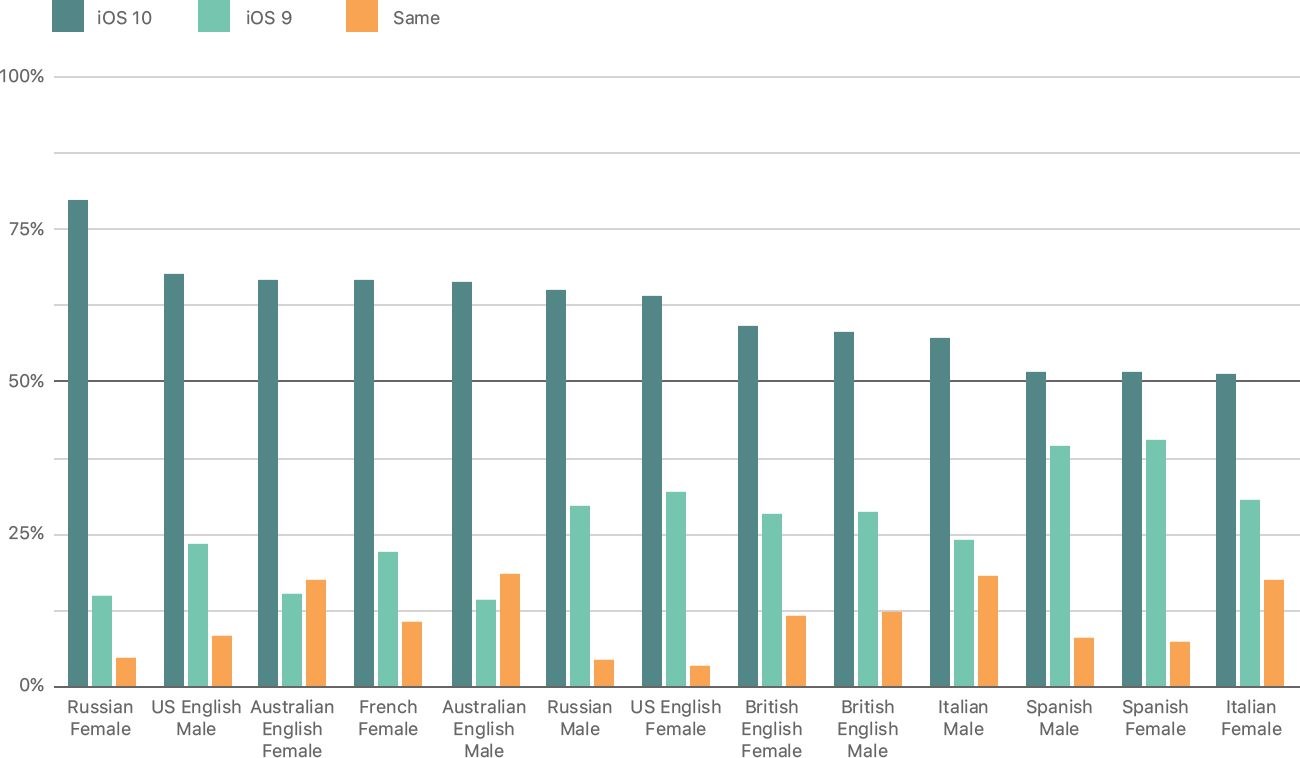

下图显示了 AB 对主观听力测试的结果:

此外,测试对象认为,这个声音完全匹配Siri的”个性”。iOS 应用开发服务提供商正在研究此技术,以了解他们如何利用该技术来构建更具创新性的应用程序。

用户何时才能体验 Siri 的新语音?

iPhone 8 将是首款配备 iOS 11 和 Siri 新语音的 Apple 手机。最新的iPad版本也将采用新的个人助理语音。苹果从未停止尝试技术来发现新的可能性。现在Siri的声音得到了改进,苹果现在处于观察阶段,了解最终用户的反应。

人工智能和深度学习正在加强其在虚拟个人助理和其他应用中的使用方面的根源。这些技术的未来似乎相当光明,因为人们正对此做出积极反应。