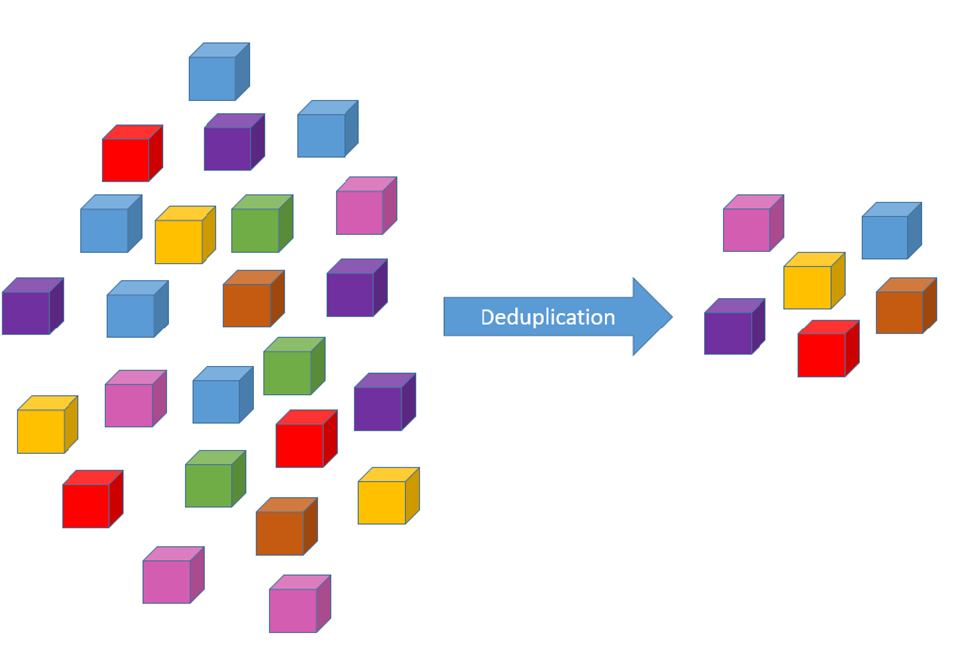

重复数据删除是一种用于消除数据集中重复记录或行的技术。由于大数据环境中处理的数据规模和数量,重复数据删除在大数据世界中具有重要意义。

以下是重复数据删除在大数据环境中至关重要的一些关键原因:

- 存储效率:大数据系统处理各种来源生成的大量数据。存储冗余数据会消耗大量的存储空间。重复数据删除可消除重复记录,降低存储要求并优化存储效率。

- 节省成本:存储和管理大量数据的成本可能很高。通过重复数据删除,组织可以显着降低存储成本,从而节省基础设施和维护成本。

- 处理速度更快:处理大型数据集时,重复数据删除可以缩短数据访问时间并提高查询性能。由于需要处理的冗余数据较少,因此可以更快地执行查询和分析,从而更快地获得洞察和决策。

- 数据质量和一致性:重复数据可能会导致数据不一致和分析错误。通过删除重复项,可以提高数据质量,确保分析和商业智能报告准确可靠。

- 简化数据工作流程:大数据工作流程通常涉及多个来源的数据集成。重复数据删除通过减少要处理的唯一数据记录的数量来简化集成过程。

- 增强的数据分析:在处理干净且经过重复数据删除的数据时,大数据分析和机器学习模型可以更加准确。消除重复可确保算法不受重复数据点的影响。

- 备份和灾难恢复:重复数据删除在备份和灾难恢复场景中也很有价值。在备份中存储唯一数据可以降低备份存储要求并缩短恢复时间。

- 数据隐私和合规性:在需要对敏感数据进行匿名化或假名化以保证隐私和法规合规性的情况下,重复数据删除可以帮助维护数据隐私,同时最大限度地降低因重复而被重新识别的风险。

- 数据治理:维护干净且经过重复数据删除的数据可支持有效的数据治理实践。它确保数据一致、维护良好并遵守数据治理政策。

- 可扩展性:重复数据删除技术需要具有可扩展性,才能处理大数据环境中生成的大量数据。高效的重复数据删除算法和分布式计算可以确保可扩展性和高性能处理。

我的 YouTube 频道<中讨论了多个此类主题< /a>.请拜访。我感谢您的支持。

在 Hive 中,可以使用多种方法来实现重复数据删除,例如使用 DISTINCT 关键字、GROUP BY 或诸如 ROW_NUMBER()< 之类的窗口函数< /代码>。让我们通过代码示例和实时场景来探索这些方法。

假设我们有一个名为 sales_data 的 Hive 表,其结构如下:

|

product_id |

sale_amount |

sale_date |

|

|

|

|

|

|

|

|

|

|

|

|

product_id |

sale_amount |

sale_date |

|

|

1 |

ABC123 |

100 |

2023-07-01 |

|

2 |

DEF456 |

50 |

2023-07-02 |

|

3 |

GHI789 |

75 |

2023-07-03 |

|

4 |

ABC123 |

100 |

2023-07-01 |

|

5 |

XYZ999 |

200 |

2023-07-04 |

|

product_id |

sale_amount |

sale_date |

|

|

1 |

ABC123 |

100 |

2023-07-01 |

|

2 |

DEF456 |

50 |

2023-07-02 |

|

3 |

GHI789 |

75 |

2023-07-03 |

|

5 |

XYZ999 |

200 |

2023-07-04 |

|

product_id |

sale_amount |

sale_date |

|

|

1 |

ABC123 |

100 |

2023-07-01 |

|

2 |

DEF456 |

50 |

2023-07-02 |

|

3 |

GHI789 |

75 |

2023-07-03 |

|

5 |

XYZ999 |

200 |

2023-07-04 |